Смертоносные свиньи жидкого герметизатора

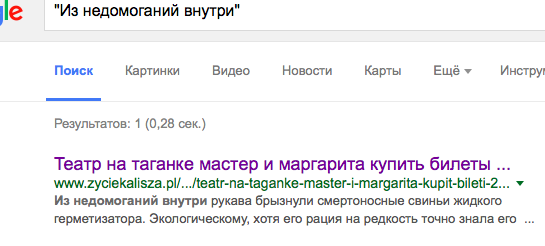

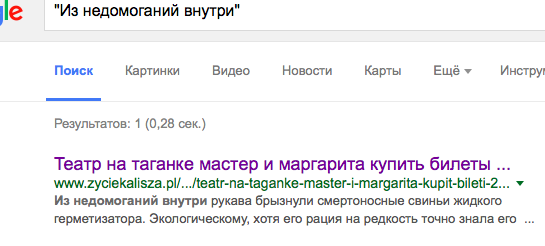

Подумалось чёто про бигдату. Гугл, например, ходит и прилежно индексирует интернет, в котором, благодаря нашим друзьям сеошникам и прочим спамерам, процентов 50 текстов выглядит как-то так:

Ну как бы ладно, благодаря поведенческим факторам, поисковики в выдаче научились подобный мусор не показывать. Но ведь потом по этим данным ходит разная бигдата, тщательно подсчитывая статистику нграмм, строя всяческие индексы, подготавливая данные для автоматических переводчиков, пейджранков и тд. Насколько бы продуктивней всё это работало бы в чистом интернете?

Вот, к примеру, очень многие пытаются побигдатить твиттер. Там же чудовищный поток данных, сотни миллионов живых активных пользователей, терабайты твитов в сутки, всё открыто, ходи и забирай по официальному API. Народ пытается предсказывать курсы акций и валют, очередные оранжевые революции, какие-то тренды, чёрти что. Но блин эти данные настолько катастрофически низкого качества, что что-то толком намайнить по ним невозможно.

Основная масса потока, это разнообразный спам и другие роботы, а львиная часть остального - твиты, вида: "@LAWBDM пожалуйста *осторожно погладила по голове*" и "ну почему почему напиши плес пожалуйста я же писала напиши веду себя как телка господи аааа*". Можно, конечно, майнить по конкретным аккаунтам, но выборка получается очень смещённая, ничего по этому предсказать нельзя.

Похоже, что у нас в 21 веке появилось много полезных инструментов для бигдаты, но вот самой даты в интернете что-то нет. Наверно, единственно полезное её применение - это обработка научных данных (с телескопов там, датчиков/зондов и тд).

Ну как бы ладно, благодаря поведенческим факторам, поисковики в выдаче научились подобный мусор не показывать. Но ведь потом по этим данным ходит разная бигдата, тщательно подсчитывая статистику нграмм, строя всяческие индексы, подготавливая данные для автоматических переводчиков, пейджранков и тд. Насколько бы продуктивней всё это работало бы в чистом интернете?

Вот, к примеру, очень многие пытаются побигдатить твиттер. Там же чудовищный поток данных, сотни миллионов живых активных пользователей, терабайты твитов в сутки, всё открыто, ходи и забирай по официальному API. Народ пытается предсказывать курсы акций и валют, очередные оранжевые революции, какие-то тренды, чёрти что. Но блин эти данные настолько катастрофически низкого качества, что что-то толком намайнить по ним невозможно.

Основная масса потока, это разнообразный спам и другие роботы, а львиная часть остального - твиты, вида: "@LAWBDM пожалуйста *осторожно погладила по голове*" и "ну почему почему напиши плес пожалуйста я же писала напиши веду себя как телка господи аааа*". Можно, конечно, майнить по конкретным аккаунтам, но выборка получается очень смещённая, ничего по этому предсказать нельзя.

Похоже, что у нас в 21 веке появилось много полезных инструментов для бигдаты, но вот самой даты в интернете что-то нет. Наверно, единственно полезное её применение - это обработка научных данных (с телескопов там, датчиков/зондов и тд).