Рэймонд Курцвейл. Закон ускоряющейся отдачи. (часть 2)

Предыдущая часть

Происхождение Закона Мура

Прежде чем рассматривать далее последствия Сингулярности, давайте рассмотрим широкий спектр технологий, которые подчиняются Закону ускоряющейся отдачи. Экспоненциальный тренд, который получил наибольшее общественное признание, известен как "Закон Мура". Гордон Мур, один из изобретателей интегральных схем, впоследствии возглавивший Intel, в середине 1970-х годов заметил, что мы можем увеличивать количество транзисторов на единицу площади в интегральных схемах вдвое каждые 24 месяца. Учитывая, что у электронов при этом сокращается расстояние, на которое они путешествуют, микросхемы при этом и ускоряются вдвое, обеспечивая в целом учетверение вычислительной мощности.

После шестидесяти лет преданного служения, закон Мура умрёт достойной смертью не позднее 2019 года. К тому времени, элементы транзисторов будут размером всего в несколько атомов, и использование даже самой тонкой фотолитографии подойдёт к своему пределу. И что, будет ли это концом экспоненциального роста вычислительной мощности?

Не рассчитывайте на это.

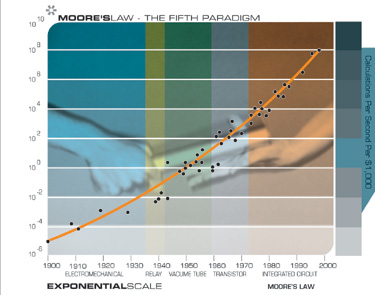

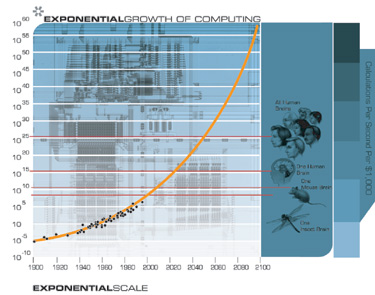

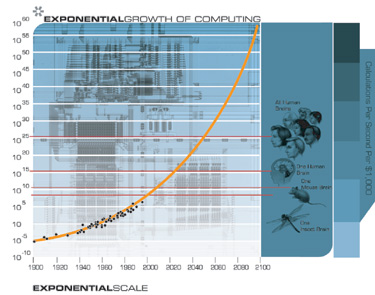

Если мы построим график скорости вычислений (в инструкциях в секунду) доступных за $1000 (в постоянных долларах) для 49 известных калькуляторов и компьютеров, охватывающих весь ХХ век, мы можем сделать некоторые интересные наблюдения.

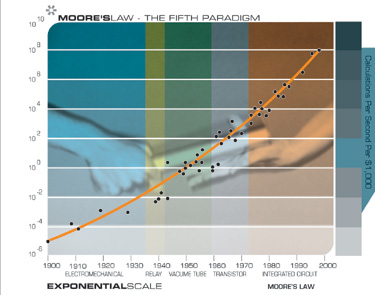

Закон Мура был не первой, а пятой, парадигмой, обеспечивавшей экспоненциальный рост вычислительной техники.

Каждый раз, когда одна парадигма выдыхается, другая набирает темп.

Важно отметить, что закон Мура для интегральных схем был не первой, а пятой парадигмой, обеспечивавшей ускорение роста соотношения цена-производительность. Вычислительные устройства постоянно умножали свою мощность (за единицу времени), от механических счётных устройств, использовавшихся при переписи населения США 1890 года, к Тьюринговской машине "Robinson", выполненной на электромеханических реле, и взламывавшей секретные нацистские коды, к ламповому компьютеру CBS, предсказавшему избрание Эйзенхауэра, к машинам на основе транзисторов, использовавшихся для первых космических запусков, к персональному компьютеру на основе интегральных микросхем, который я использовал, чтобы диктовать (и автоматически транскрибировать) это эссе.

Но я заметил ещё кое-что удивительное. Когда я нанёс 49 машин на экспоненциальный график (где прямая линия означает экспоненциальный рост), я не получил прямой линии. То, что я получил, было другой экспоненциальной кривой. Другими словами, это экспоненциальный рост скорости экспоненциального роста. Скорость компьютеров (на единицу стоимости) удваивалась каждые три года в период с 1910 по 1950 год, удваивалась каждые два года в период между 1950 и 1966 годами, а в настоящее время удваивается каждый год.

Но откуда же берётся Закон Мура? Что стоит за этим удивительно предсказуемым явлением? Я встретил довольно мало работ о первоисточнике этой тенденции. Является ли она просто "набором отраслевых целей и ожиданий", как утверждает Рэнди Исаак (Randy Isaac), глава фундаментальной науки в IBM? Или происходит что-то более глубинное?

На мой взгляд, это одно (среди многих) из проявлений экспоненциального роста эволюционного процесса, которым является развитие технологий. Экспоненциальный рост вычислительной техники является изумительным исчислимым примером экспоненциально увеличивающейся отдачи от эволюционного процесса. Мы также можем выразить экспоненциальный рост вычислительной техники в терминах ускоряющегося темпа развития: потребовалось девяносто лет, чтобы достичь первого MIPS-а (миллиона инструкций в секунду) на тысячу долларов, а теперь мы добавляем по MIPS-у на тысячу долларов каждый день.

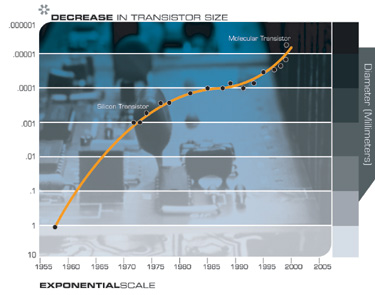

Закон Мура в узком смысле относится к числу транзисторов на интегральной схеме фиксированного размера, и иногда выражался ещё более узко, в терминах размера элемента транзистора. Но вместо размера элемента (который является лишь одним из влияющих факторов), или даже количества транзисторов, я думаю, что наиболее подходящей для отслеживания мерой является отношение скорости вычислений к стоимости вычислительного модуля. При этом учитывается множество уровней "совершенства" (то есть, инноваций, которые, суть, и есть технологическая эволюция). В дополнение ко всем инновациям в интегральных схемах, есть несколько уровней инноваций в компьютерном дизайне, таких, как конвейерная обработка, параллельная обработка, предварительная выборка команд, кэширование инструкций и данных, и многое другое.

Из приведённого выше графика мы видим, что экспоненциальный рост вычислительной техники начался не с интегральных схем (около 1958 года), или даже транзисторов (около 1947 года), а восходит к электромеханическим калькуляторам, использовавшимся в переписи населения США в 1890 и 1900 годах. Эта диаграмма охватывает по меньшей мере пять различных парадигм вычислений, из которых закон Мура имеет отношение только к последней.

Очевидно, какой будет шестая парадигма после того, как закон Мура выдохнется во втором десятилетии нынешнего века. Чипы сегодня плоские (хотя и требуется до 20 слоёв материала, чтобы произвести один слой схемы). В отличие от этого, наш мозг организован в трёх измерениях. Мы живём в трёхмерном мире, почему бы не использовать третье измерение? Человеческий мозг на самом деле использует очень неэффективный электрохимический аналоговый вычислительный процесс с цифровым управлением. Основная часть расчётов осуществляется в межнейронных соединениях со скоростью всего около 200 операций в секунду (на каждом соединении), что примерно в десять миллионов раз медленнее, чем у современных электронных схем. Но мозг получает свою умопомрачительную мощность от своей высоко-параллельной организации в трёх измерениях. На подходе уже есть множество технологий, которые работают в трёх измерениях. Например, нанотрубки, с которыми уже работают в лабораториях, строят схемы из пентагональных массивов углеродных атомов. Схема из пятнадцати кубических сантиметров нанотрубок будет в миллион раз более мощной, чем человеческий мозг. В настоящее время исследуется более чем достаточно новых компьютерных технологий, в том числе трёхмерные кремниевые чипы, оптические вычисления, кристаллические вычисления, вычисления на основе ДНК и квантовые вычисления, чтобы сохранить действие закона ускоряющейся отдачи, применительно к вычислительной технике, на длительное время.

Таким образом, (двойной) экспоненциальный рост вычислительной техники шире, чем закон Мура, который относится только к одной из парадигм этого роста. И это ускорение развития вычислительной техники, в свою очередь, является частью ещё более широкого явления ускорения темпов любого эволюционного процесса. Критики спешат заметить, что экстраполяция экспоненциального тренда ограничивается исчерпанием "ресурсов". Классическим примером является следующая ситуация: когда вид появляется в новом ареале обитания (например, кролики в Австралии), численность вида некоторое время растёт в геометрической прогрессии, но затем, когда заканчиваются ресурсы, такие, как место и продукты питания, численность упирается в предел роста.

Но ресурсы, лежащие в основе экспоненциального роста эволюционного процесса, относительно неограничены:

Реальной проблемой является максимальный потенциал материи и энергии, в котором функционируют интеллектуальные процессы. Но, согласно моим моделям, мы не подойдём к их пределам в течение текущего столетия (но это, однако, станет проблемой в следующие пару столетий).

Нам также нужно различать "S-образную кривую" ("S" растянутую вправо, включающую в себя очень медленный, практически незаметный рост с последующим очень быстрым ростом, а затем его уплощение, по мере того, как процесс приближается к асимптоте), которая характерна для какой-либо конкретной технологической парадигмы, и продолжающийся экспоненциальный рост, характерный для продолжающегося эволюционного развития технологии. Конкретные парадигмы, такие как закон Мура, в конце концов достигают уровней, при которых экспоненциальный рост уже не представляется возможным. Таким образом, закон Мура является S-образной кривой. Однако, рост вычислительной мощности является непрерывным экспоненциальным процессом (по крайней мере, пока мы не "насытим" Вселенную интеллектом нашей человеческого-машинной цивилизации, но это не станет ограничением в наступающем столетии). В соответствии с законом ускоряющейся отдачи, смена парадигмы, называемая также инновацией, превращает S-образную кривую какой-либо конкретной парадигмы в продолжение экспоненциального роста. Новая парадигма (например, трёхмерные схемы) начинает превалировать, когда старая парадигма приближается к своему естественному пределу. В истории вычислений так происходило уже, по крайней мере, четыре раза. Эта особенность также отличает изготовление орудий труда у других видов животных, у которых навык изготовления (или использования) орудия труда у каждого конкретного животного характеризуется резко заканчивающейся S-образной кривой обучения, от технологий, созданных человеком, которые имеют экспоненциальный характер скорости роста с момента своего создания.

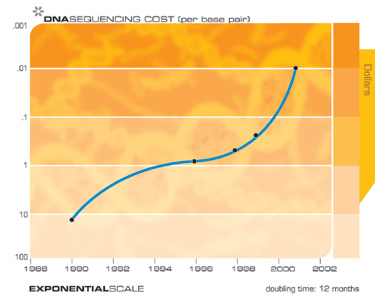

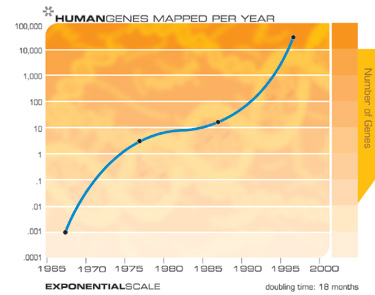

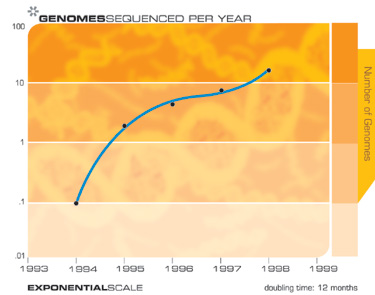

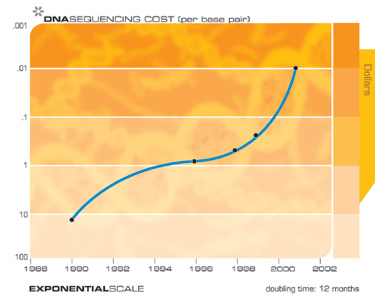

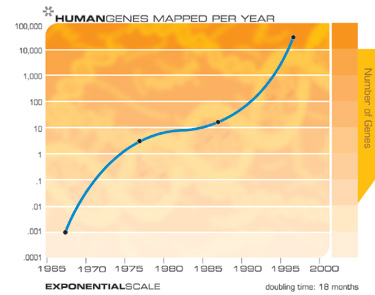

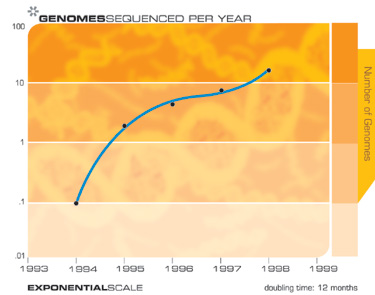

Секвенирование ДНК, память, связь, интернет и миниатюризация

"Закон ускоряющейся отдачи" применим к любым технологиям, к любому по-настоящему эволюционному процессу, и может быть измерен с поразительной точностью для технологий информационных. Есть очень много примеров экспоненциального роста, вытекающего из Закона ускоряющейся отдачи, в таких разнообразных технологически областях, как секвенирование ДНК, скорость связи, электроника всех видов, и даже в быстро сокращающихся характерных технологических размерах. Сингулярность возникает не из одного экспоненциального взрыва скорости вычислений, а, скорее, из взаимодействия и синергии, являющихся следствием многообразного переплетения различных технологических революций. Также нужно иметь в виду, что каждая точка на кривых экспоненциального роста, лежащих в основе этого арсенала технологий (см. графики ниже) представляет собой серьёзную людскую драму внедрения новшеств и конкуренции. Удивительно, что эти хаотические процессы приводят к такой гладкой и предсказуемой экспоненциальной зависимости.

Например, когда четырнадцать лет назад началось секвенирование генома человека, критики полагали, что, учитывая скорость секвенирования, которая тогда была доступна, на завершение проекта может потребоваться несколько тысяч лет. Тем не менее, на пятнадцатый год проект был завершён, немного раньше намеченного срока.

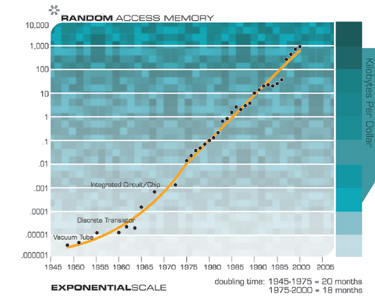

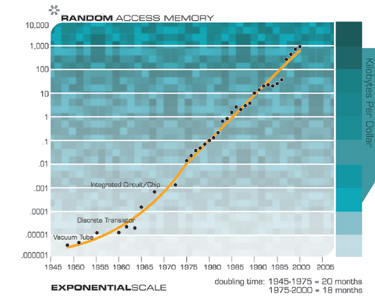

Конечно, мы ожидаем увидеть экспоненциальный рост в технологии электронных запоминающих устройств, таких как RAM (оперативная память произвольного доступа).

Обратите внимание, как экспоненциальный рост продолжался при смене парадигмы от вакуумных трубок к дискретным транзисторам и далее, к интегральным микросхемам.

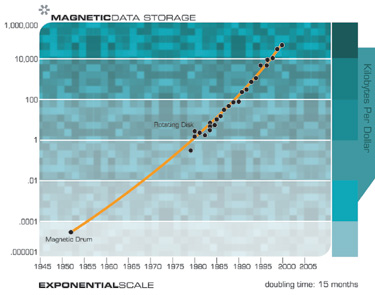

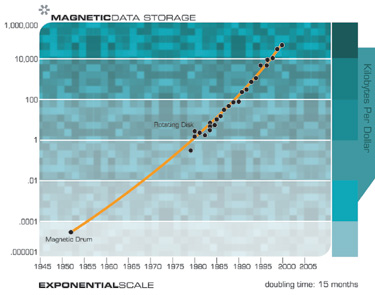

Развитие технологий магнитной памяти на связано напрямую с Законом Мура, а опирается на достижения в области механических и электромагнитных систем.

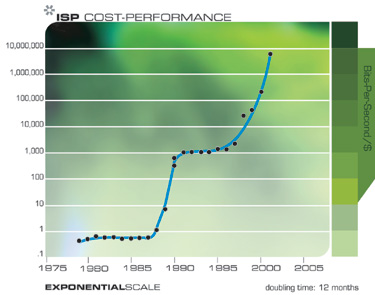

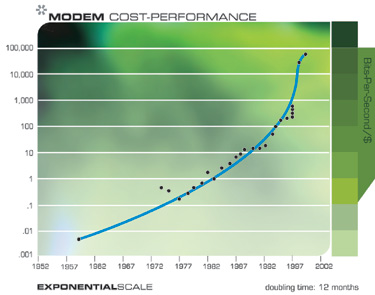

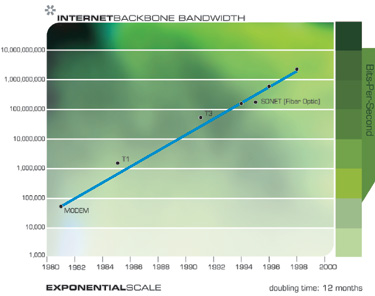

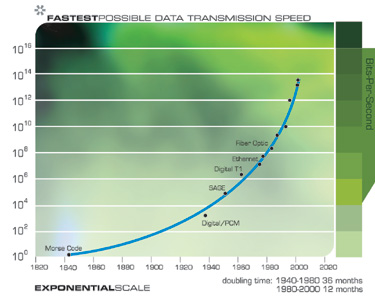

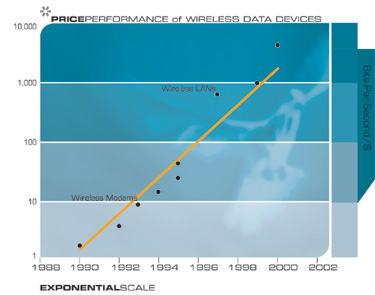

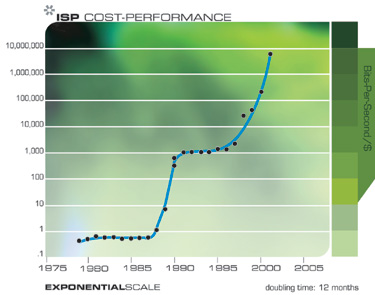

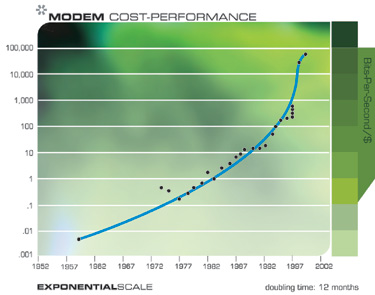

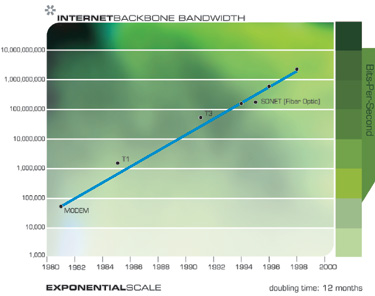

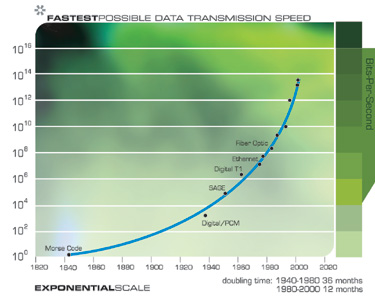

Экспоненциальный рост в области коммуникационных технологий был ещё более взрывным, чем в области вычислений, и не менее значителен по своим последствиям. Опять же, это ускорение имеет гораздо более широкую базу, чем просто уменьшение размера транзисторов на кристалле, и включает в себя ускоряющийся прогресс в области волоконной оптики, оптической коммутации, электромагнитных технологиях и многом другом.

Обратите внимание на каскад небольших "S-образных" кривых

Обратите внимание, что на этих двух графиках мы можем реально увидеть прогрессирование "S-образных" кривых: ускорение, обусловленное новой парадигмой, затем стабилизация, по мере того, как парадигма выдыхается, и последующее возобновление быстрого роста после смены парадигмы.

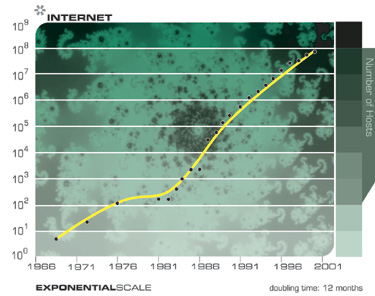

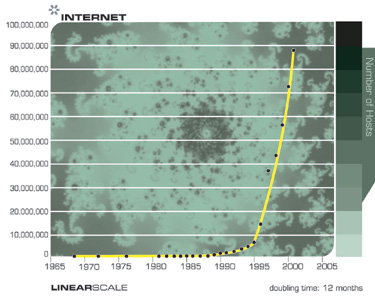

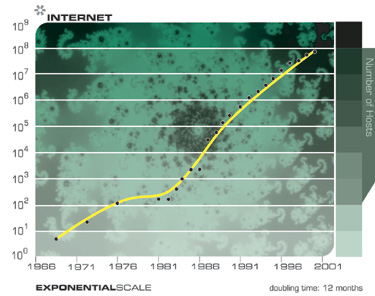

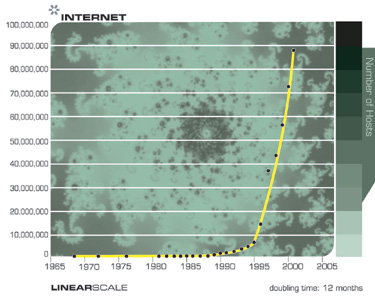

Следующие две диаграммы показывают общий рост Интернета, выраженный в количестве сайтов. Эти два графика построены на одних и тех же данных, но один из них в экспоненциальном масштабе, а другой является линейным. Как я отмечал ранее, технология, прогрессирующая с экспоненциальным темпом, кажется нам развивающейся линейно. Таким образом, большинству наблюдателей будет казаться, что до середины 1990-х годов, когда, казалось бы, из ниоткуда, стремительно возникли всемирная паутина и электронная почта, ничего не происходило. Но превращение Интернета во всемирное явление было легко предсказуемо гораздо раньше, на основе данных экспоненциального тренда.

Обратите внимание на то, каким сюрпризом выглядит взрывной рост Интернета на линейном графике, и как он предсказуем на графике экспоненциальном.

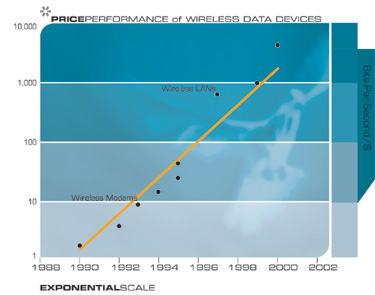

В конце концов мы уйдём от путаницы проводов в наших городах и в нашей жизни к беспроводной связи, производительность которой удваивается каждые 10-11 месяцев.

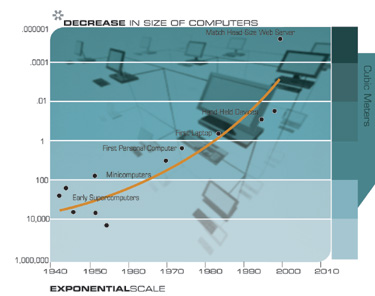

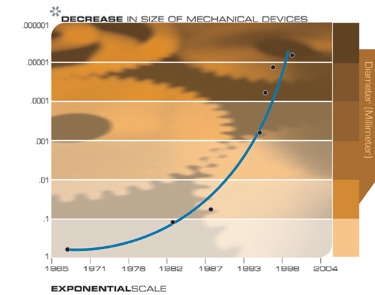

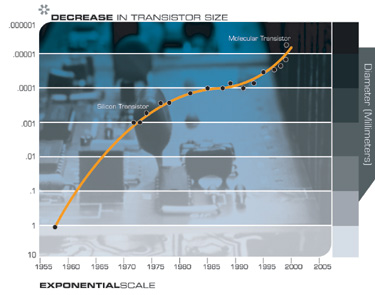

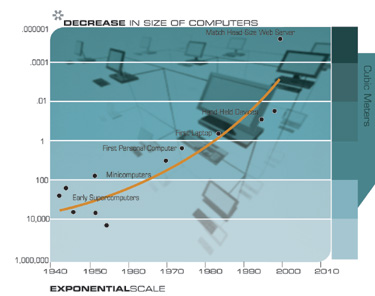

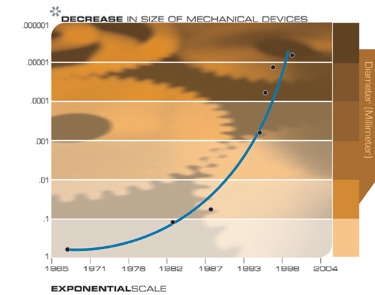

Ещё одна технология, которая будет иметь далеко идущие последствия для двадцать первого века, - это повсеместная тенденция делать вещи меньше, то есть миниатюризация. Характерные размеры элементов широкого спектра технологий, как электронных, так и механических, сокращаются, и также с удвоенной экспоненциальной скоростью. В настоящее время уменьшение линейных размеров по каждому измерению происходит с коэффициентом примерно 5,6 за каждое десятилетие.

Вернёмся к экспоненциальному росту вычислений

Если мы рассматриваем экспоненциальный рост вычислений в правильной перспективе, в качестве одного из примеров широкой распространённости экспоненциального роста, основанного на информационных технологиях, что и является одним из множества примеров Закона ускоряющейся отдачи, то мы можем с уверенностью предсказать его продолжение.

В сопроводительной врезке, я даю упрощённую математическую модель Закона ускоряющейся отдачи, поскольку она имеет отношение к (двойному) экспоненциальному росту вычислительной мощности. Из формул, приведённых ниже, следует приведённый выше график непрерывного роста скорости вычислений. Этот график соответствует имеющимся данным для двадцатого века, проходит через все пять смен парадигм, и даёт прогноз на век двадцать первый. Обратите внимание, что скорость роста увеличивается медленно, но всё-таки в геометрической прогрессии.

Закон ускоряющейся отдачи применительно к росту вычислений

Ниже приводится краткий обзор Закона ускоряющейся отдачи на примере двойного экспоненциального роста скорости вычислений. Эта модель рассматривает влияние растущей мощности технологии в качестве стимула для развития своего собственного следующего поколения. Например, с более мощными компьютерами, и связанными с ними технологиями, мы получаем инструменты и знания, чтобы разработать ещё более мощные компьютеры, и сделать это ещё быстрее.

Обратите внимание, что данные за 2000 год и последующие периоды, представляют вычисления в нейронных сетях, поскольку ожидается, что именно этот вид расчётов, в конечном счёте, будет доминировать, особенно при эмуляции функций мозга человека. Этот тип расчётов является менее затратным, чем обычные (например, для Pentium III / IV) расчёты, с коэффициентом по меньшей мере 100 (особенно, в случае их реализации с использованием цифро-аналоговой электроники, которая будет хорошо соответствовать цифро-аналоговым электрохимическим процессам мозга). Коэффициент 100 соответствует примерно шести годам сегодня, и менее чем шести годам далее в двадцать первом веке.

Моя оценка производительности мозга составляет 100 миллиардов нейронов умножить на, в среднем, 1000 соединений на нейрон (вычисления происходят, в основном, в соединениях), и умножить на 200 операций в секунду. Конечно, эти оценки консервативно высоки, можно найти и более высокие и более низкие оценки. Тем не менее, даже гораздо более (или менее) высокие по порядку величины оценки, смещают прогноз всего на относительно небольшое число лет.

Некоторые из наиболее значимых дат этого анализа:

Модель имеет следующие переменные:

В модели предполагается, что:

Другими словами, мощность компьютеров является линейной функцией от знания о том, как их создавать. На самом деле, это консервативное предположение. Обычно, инновации улучшают V (производительность компьютера) в разы, а не на фиксированную величину. Независимые инновации умножают эффект друг друга. Например, новая технология полупроводников, такая, как CMOS, более эффективная методика разводки интегральных схем, и улучшение архитектуры процессора, такое, как конвейерная обработка, независимо и кратно увеличивают V.

Другими словами, W (знание) является кумулятивным, и мгновенное приращение знаний пропорционально V.

Это даёт нам:

Упрощая константы получаем:

Таким образом, это формула для "ускоряющегося" (то есть, растущего в геометрической прогрессии), результата, фактически "обычный закон Мура".

Как я уже упоминал выше, данные показывают экспоненциальный рост скорости экспоненциального роста. (Мы удваивали вычислительные мощности каждые три года в начале двадцатого века, каждые два года в середине века, и почти каждый год в течение 1990-х гг.)

Давайте рассмотрим другое экспоненциальное явление, которым является рост вычислительных ресурсов. Мало того, что каждое из вычислительных устройств (одинаковой стоимости) становится всё более мощным, как функция от W, но и их количество, используемое для вычислений, также растёт экспоненциально.

Таким образом, мы имеем:

Как и прежде, мировые знания накапливаются, и мгновенное приращение пропорционально количеству вычислений, которые равны ресурсам, используемым для вычислений (N) умноженным на мощность каждого устройства (при его постоянной стоимости).

Это даёт нам:

Упрощая константы, получаем:

Это двойная экспоненциальная кривая, в ней скорость экспоненциального роста растёт со своей экспоненциальной скоростью.

Теперь давайте рассмотрим реальные данные. Возьмём параметры реальных вычислительных устройств и компьютеров в двадцатом веке:

Данные по вычислительным устройствам двадцатого века соответствуют:

Мы можем определить темпы роста в течение определённого периода времени:

Эти формулы и дают приведённые выше графики.

Уже сейчас ожидается, что суперкомпьютер от IBM "Blue Gene", создание которого планируется завершить к 2005 году, будет, по прогнозам, способен выполнять 1 миллион миллиардов операций в секунду (т.е. один миллиард мегафлопсов или один петафлопс). Это уже одна двадцатая производительности человеческого мозга, которую я консервативно оцениваю в 20 миллионов миллиардов операций в секунду (100 миллиардов нейронов на 1000 соединений в нейроне на 200 вычислений в секунду на одно соединение). В соответствии с моими предыдущими прогнозами, суперкомпьютеры достигнут мощности одного человеческого мозга к 2010 году, а персональные компьютеры сделают это примерно к 2020 году. К 2030 году потребуется уже небольшое поселение (около тысячи человек), чтобы соответствовать вычислительной мощности, доступной за \$1000. К 2050 году, за \$1000 можно будет получить вычислительные мощности, эквивалентные разуму всех людей на Земле. Конечно, это включает в себя только те мозги, которые всё ещё используют нейроны на основе углерода. Хотя человеческие нейроны, по сути, дивные творения, нам не стоит (да мы и не будем) их просто копировать при разработке новых компьютерных систем. Наши электронные схемы уже в десятки миллионов раз быстрее, чем электрохимические процессы нейрона. Большая часть сложности человеческого нейрона используется для поддержания его функций жизнеобеспечения, а не на возможности по обработке информации. В конечном счёте, мы должны перенести наши психические процессы на более подходящую вычислительную основу. Тогда нашим умам не нужно будет оставаться настолько маленькими, будучи ограниченным, как они ограничены сегодня, всего лишь ста триллионами нейронных связей, каждая из которых работает с медлительностью в 200 цифро-аналоговых вычислений в секунду.

Программное обеспечение интеллекта

До сих пор я говорил об аппаратном обеспечении вычислительной техники. Программное обеспечение ещё более показательно. Одним из основных допущений, лежащих в основе предсказания Сингулярности, является способность небиологических сред воспроизводить богатство, тонкость и глубину человеческого мышления. Достижение вычислительной мощности одного человеческого мозга, или даже поселения или нации, не будет автоматически давать уровень возможностей человека. Под человеческим уровнем я понимаю все разнообразные и изощрённые пути проявления человеческого интеллекта, в том числе музыкальные и художественные способности, творчество, способность физически перемещаться в пространстве, понимание, и адекватную реакцию на эмоции. Соответствующая мощность аппаратных средств является необходимым, но не достаточным условием. Организация и содержимое этих ресурсов - программное обеспечение интеллекта, также имеет решающее значение.

Прежде чем рассматривать этот вопрос, важно отметить, что, как только компьютер достигнет человеческого уровня интеллекта, он обязательно его перешагнёт. Ключевым преимуществом небиологического интеллекта является то, что машины могут легко делиться своими знаниями. Если я учу французский, или читаю Войну и мир, я не могу легко загрузить то, что узнал сам, вам. Вы должны получить эти знания тем же кропотливым путём, как это сделал я. Мои знания, встроенные в огромную структуру концентраций нейромедиаторов и нейронных связей, не могут быть быстро извлечены или переданы. Но мы не упустим возможности создания быстрых каналов передачи данных в наших небиологических эквивалентах кластеров человеческих нейронов. Когда один компьютер обучается навыку или приходит к пониманию чего-либо, он может немедленно разделить эту мудрость с миллиардами других машин.

В качестве современного примера - мы потратили годы обучения одного исследовательского компьютера на распознавание слитной человеческой речи. Мы пропустили через него тысячи часов записанной речи, исправляли его ошибки, и терпеливо улучшали его показатели. Наконец, он стал весьма искусными в распознавании (я продиктовал ему большую часть своей, недавно вышедшей, книги). Теперь, если вы хотите, чтобы ваш собственный персональный компьютер распознавал речь, его не нужно пропускать через тот же процесс заново; вы можете просто загрузить полностью подготовленные шаблоны за считанные секунды. В конечном итоге, миллиарды небиологических сущностей могут быть главным хранилищем всех знаний, приобретённых людьми и машинами.

Кроме того, компьютеры потенциально в миллионы раз быстрее, чем нейронные цепи человека. Компьютер также может точно запомнить миллиарды или даже триллионы фактов, в то время как мы с трудом запоминаем несколько телефонных номеров. Сочетание в машине интеллекта человеческого уровня со свойственным компьютерам превосходством в скорости, точности и совместном использовании знаний будет грандиозным.

Существует целый ряд убедительных сценариев достижения более высоких уровней интеллекта в наших компьютерах, в конечном итоге, приближающихся к уровню человека, и превосходящих его. Мы сможем развивать и обучать систему, комбинируя нейронные сети с массовым параллелизмом с другими парадигмами для того, чтобы понимать язык и строить модели знаний, в том числе уметь извлекать эти знания из письменных документов. В отличие от многих современных компьютерных "нейронных сетей", которые используют математически упрощённые модели человеческих нейронов, некоторые современные нейронные сети уже используют высоко детализированные модели человеческих нейронов, включающие точные функции нелинейной аналоговой активации и другие подобные детали. Хотя способность современных компьютеров к извлечению знаний и обучению на документах на естественных языках ограничена, их возможности в этой области быстро улучшаются. Компьютеры смогут самостоятельно читать, понимая и моделируя то, что они прочли, во втором десятилетии двадцать первого века. Затем мы сможем дать нашим компьютерам прочитать всю существующую в мире литературу - книги, журналы, научные издания, и другие материалы. В конце концов, машины будут собирать знания самостоятельно, роясь в Интернете, или даже в физическом мире, извлекая информацию из всего спектра средств массовой информации и информационных услуг, и обмениваясь знаниями друг с другом (что машины смогут делать гораздо легче, чем их создатели - люди).

Продолжение следует...

Происхождение Закона Мура

Прежде чем рассматривать далее последствия Сингулярности, давайте рассмотрим широкий спектр технологий, которые подчиняются Закону ускоряющейся отдачи. Экспоненциальный тренд, который получил наибольшее общественное признание, известен как "Закон Мура". Гордон Мур, один из изобретателей интегральных схем, впоследствии возглавивший Intel, в середине 1970-х годов заметил, что мы можем увеличивать количество транзисторов на единицу площади в интегральных схемах вдвое каждые 24 месяца. Учитывая, что у электронов при этом сокращается расстояние, на которое они путешествуют, микросхемы при этом и ускоряются вдвое, обеспечивая в целом учетверение вычислительной мощности.

После шестидесяти лет преданного служения, закон Мура умрёт достойной смертью не позднее 2019 года. К тому времени, элементы транзисторов будут размером всего в несколько атомов, и использование даже самой тонкой фотолитографии подойдёт к своему пределу. И что, будет ли это концом экспоненциального роста вычислительной мощности?

Не рассчитывайте на это.

Если мы построим график скорости вычислений (в инструкциях в секунду) доступных за $1000 (в постоянных долларах) для 49 известных калькуляторов и компьютеров, охватывающих весь ХХ век, мы можем сделать некоторые интересные наблюдения.

Закон Мура был не первой, а пятой, парадигмой, обеспечивавшей экспоненциальный рост вычислительной техники.

Каждый раз, когда одна парадигма выдыхается, другая набирает темп.

Важно отметить, что закон Мура для интегральных схем был не первой, а пятой парадигмой, обеспечивавшей ускорение роста соотношения цена-производительность. Вычислительные устройства постоянно умножали свою мощность (за единицу времени), от механических счётных устройств, использовавшихся при переписи населения США 1890 года, к Тьюринговской машине "Robinson", выполненной на электромеханических реле, и взламывавшей секретные нацистские коды, к ламповому компьютеру CBS, предсказавшему избрание Эйзенхауэра, к машинам на основе транзисторов, использовавшихся для первых космических запусков, к персональному компьютеру на основе интегральных микросхем, который я использовал, чтобы диктовать (и автоматически транскрибировать) это эссе.

Но я заметил ещё кое-что удивительное. Когда я нанёс 49 машин на экспоненциальный график (где прямая линия означает экспоненциальный рост), я не получил прямой линии. То, что я получил, было другой экспоненциальной кривой. Другими словами, это экспоненциальный рост скорости экспоненциального роста. Скорость компьютеров (на единицу стоимости) удваивалась каждые три года в период с 1910 по 1950 год, удваивалась каждые два года в период между 1950 и 1966 годами, а в настоящее время удваивается каждый год.

Но откуда же берётся Закон Мура? Что стоит за этим удивительно предсказуемым явлением? Я встретил довольно мало работ о первоисточнике этой тенденции. Является ли она просто "набором отраслевых целей и ожиданий", как утверждает Рэнди Исаак (Randy Isaac), глава фундаментальной науки в IBM? Или происходит что-то более глубинное?

На мой взгляд, это одно (среди многих) из проявлений экспоненциального роста эволюционного процесса, которым является развитие технологий. Экспоненциальный рост вычислительной техники является изумительным исчислимым примером экспоненциально увеличивающейся отдачи от эволюционного процесса. Мы также можем выразить экспоненциальный рост вычислительной техники в терминах ускоряющегося темпа развития: потребовалось девяносто лет, чтобы достичь первого MIPS-а (миллиона инструкций в секунду) на тысячу долларов, а теперь мы добавляем по MIPS-у на тысячу долларов каждый день.

Закон Мура в узком смысле относится к числу транзисторов на интегральной схеме фиксированного размера, и иногда выражался ещё более узко, в терминах размера элемента транзистора. Но вместо размера элемента (который является лишь одним из влияющих факторов), или даже количества транзисторов, я думаю, что наиболее подходящей для отслеживания мерой является отношение скорости вычислений к стоимости вычислительного модуля. При этом учитывается множество уровней "совершенства" (то есть, инноваций, которые, суть, и есть технологическая эволюция). В дополнение ко всем инновациям в интегральных схемах, есть несколько уровней инноваций в компьютерном дизайне, таких, как конвейерная обработка, параллельная обработка, предварительная выборка команд, кэширование инструкций и данных, и многое другое.

Из приведённого выше графика мы видим, что экспоненциальный рост вычислительной техники начался не с интегральных схем (около 1958 года), или даже транзисторов (около 1947 года), а восходит к электромеханическим калькуляторам, использовавшимся в переписи населения США в 1890 и 1900 годах. Эта диаграмма охватывает по меньшей мере пять различных парадигм вычислений, из которых закон Мура имеет отношение только к последней.

Очевидно, какой будет шестая парадигма после того, как закон Мура выдохнется во втором десятилетии нынешнего века. Чипы сегодня плоские (хотя и требуется до 20 слоёв материала, чтобы произвести один слой схемы). В отличие от этого, наш мозг организован в трёх измерениях. Мы живём в трёхмерном мире, почему бы не использовать третье измерение? Человеческий мозг на самом деле использует очень неэффективный электрохимический аналоговый вычислительный процесс с цифровым управлением. Основная часть расчётов осуществляется в межнейронных соединениях со скоростью всего около 200 операций в секунду (на каждом соединении), что примерно в десять миллионов раз медленнее, чем у современных электронных схем. Но мозг получает свою умопомрачительную мощность от своей высоко-параллельной организации в трёх измерениях. На подходе уже есть множество технологий, которые работают в трёх измерениях. Например, нанотрубки, с которыми уже работают в лабораториях, строят схемы из пентагональных массивов углеродных атомов. Схема из пятнадцати кубических сантиметров нанотрубок будет в миллион раз более мощной, чем человеческий мозг. В настоящее время исследуется более чем достаточно новых компьютерных технологий, в том числе трёхмерные кремниевые чипы, оптические вычисления, кристаллические вычисления, вычисления на основе ДНК и квантовые вычисления, чтобы сохранить действие закона ускоряющейся отдачи, применительно к вычислительной технике, на длительное время.

Таким образом, (двойной) экспоненциальный рост вычислительной техники шире, чем закон Мура, который относится только к одной из парадигм этого роста. И это ускорение развития вычислительной техники, в свою очередь, является частью ещё более широкого явления ускорения темпов любого эволюционного процесса. Критики спешат заметить, что экстраполяция экспоненциального тренда ограничивается исчерпанием "ресурсов". Классическим примером является следующая ситуация: когда вид появляется в новом ареале обитания (например, кролики в Австралии), численность вида некоторое время растёт в геометрической прогрессии, но затем, когда заканчиваются ресурсы, такие, как место и продукты питания, численность упирается в предел роста.

Но ресурсы, лежащие в основе экспоненциального роста эволюционного процесса, относительно неограничены:

- Порядок (постоянно растущий) самого эволюционного процесса. Каждый этап эволюции предоставляет более мощные инструменты для следующего. В биологической эволюции, появление ДНК дало основу для более мощных и быстрых эволюционных "экспериментов". Позднее, возникновение разнообразных "конструкций" организмов во время Кембрийского взрыва открыло путь к быстрому эволюционному развитию других органов тела, таких как мозг. Или взять более свежий пример, появление компьютерных инструментов проектирования позволяет ускорить создание следующего поколения компьютеров.

- "Хаос" окружающей среды, в которой происходит эволюционный процесс и который предоставляет варианты ещё большего разнообразия. В биологической эволюции, разнообразие вступает в процесс в виде мутаций и постоянно изменяющихся условий окружающей среды. В технологической эволюции, поддержка процесса инноваций происходит за счёт человеческой изобретательности в сочетании с постоянно меняющимися рыночными условиями.

Реальной проблемой является максимальный потенциал материи и энергии, в котором функционируют интеллектуальные процессы. Но, согласно моим моделям, мы не подойдём к их пределам в течение текущего столетия (но это, однако, станет проблемой в следующие пару столетий).

Нам также нужно различать "S-образную кривую" ("S" растянутую вправо, включающую в себя очень медленный, практически незаметный рост с последующим очень быстрым ростом, а затем его уплощение, по мере того, как процесс приближается к асимптоте), которая характерна для какой-либо конкретной технологической парадигмы, и продолжающийся экспоненциальный рост, характерный для продолжающегося эволюционного развития технологии. Конкретные парадигмы, такие как закон Мура, в конце концов достигают уровней, при которых экспоненциальный рост уже не представляется возможным. Таким образом, закон Мура является S-образной кривой. Однако, рост вычислительной мощности является непрерывным экспоненциальным процессом (по крайней мере, пока мы не "насытим" Вселенную интеллектом нашей человеческого-машинной цивилизации, но это не станет ограничением в наступающем столетии). В соответствии с законом ускоряющейся отдачи, смена парадигмы, называемая также инновацией, превращает S-образную кривую какой-либо конкретной парадигмы в продолжение экспоненциального роста. Новая парадигма (например, трёхмерные схемы) начинает превалировать, когда старая парадигма приближается к своему естественному пределу. В истории вычислений так происходило уже, по крайней мере, четыре раза. Эта особенность также отличает изготовление орудий труда у других видов животных, у которых навык изготовления (или использования) орудия труда у каждого конкретного животного характеризуется резко заканчивающейся S-образной кривой обучения, от технологий, созданных человеком, которые имеют экспоненциальный характер скорости роста с момента своего создания.

Секвенирование ДНК, память, связь, интернет и миниатюризация

"Закон ускоряющейся отдачи" применим к любым технологиям, к любому по-настоящему эволюционному процессу, и может быть измерен с поразительной точностью для технологий информационных. Есть очень много примеров экспоненциального роста, вытекающего из Закона ускоряющейся отдачи, в таких разнообразных технологически областях, как секвенирование ДНК, скорость связи, электроника всех видов, и даже в быстро сокращающихся характерных технологических размерах. Сингулярность возникает не из одного экспоненциального взрыва скорости вычислений, а, скорее, из взаимодействия и синергии, являющихся следствием многообразного переплетения различных технологических революций. Также нужно иметь в виду, что каждая точка на кривых экспоненциального роста, лежащих в основе этого арсенала технологий (см. графики ниже) представляет собой серьёзную людскую драму внедрения новшеств и конкуренции. Удивительно, что эти хаотические процессы приводят к такой гладкой и предсказуемой экспоненциальной зависимости.

Например, когда четырнадцать лет назад началось секвенирование генома человека, критики полагали, что, учитывая скорость секвенирования, которая тогда была доступна, на завершение проекта может потребоваться несколько тысяч лет. Тем не менее, на пятнадцатый год проект был завершён, немного раньше намеченного срока.

Конечно, мы ожидаем увидеть экспоненциальный рост в технологии электронных запоминающих устройств, таких как RAM (оперативная память произвольного доступа).

Обратите внимание, как экспоненциальный рост продолжался при смене парадигмы от вакуумных трубок к дискретным транзисторам и далее, к интегральным микросхемам.

Развитие технологий магнитной памяти на связано напрямую с Законом Мура, а опирается на достижения в области механических и электромагнитных систем.

Экспоненциальный рост в области коммуникационных технологий был ещё более взрывным, чем в области вычислений, и не менее значителен по своим последствиям. Опять же, это ускорение имеет гораздо более широкую базу, чем просто уменьшение размера транзисторов на кристалле, и включает в себя ускоряющийся прогресс в области волоконной оптики, оптической коммутации, электромагнитных технологиях и многом другом.

Обратите внимание на каскад небольших "S-образных" кривых

Обратите внимание, что на этих двух графиках мы можем реально увидеть прогрессирование "S-образных" кривых: ускорение, обусловленное новой парадигмой, затем стабилизация, по мере того, как парадигма выдыхается, и последующее возобновление быстрого роста после смены парадигмы.

Следующие две диаграммы показывают общий рост Интернета, выраженный в количестве сайтов. Эти два графика построены на одних и тех же данных, но один из них в экспоненциальном масштабе, а другой является линейным. Как я отмечал ранее, технология, прогрессирующая с экспоненциальным темпом, кажется нам развивающейся линейно. Таким образом, большинству наблюдателей будет казаться, что до середины 1990-х годов, когда, казалось бы, из ниоткуда, стремительно возникли всемирная паутина и электронная почта, ничего не происходило. Но превращение Интернета во всемирное явление было легко предсказуемо гораздо раньше, на основе данных экспоненциального тренда.

Обратите внимание на то, каким сюрпризом выглядит взрывной рост Интернета на линейном графике, и как он предсказуем на графике экспоненциальном.

В конце концов мы уйдём от путаницы проводов в наших городах и в нашей жизни к беспроводной связи, производительность которой удваивается каждые 10-11 месяцев.

Ещё одна технология, которая будет иметь далеко идущие последствия для двадцать первого века, - это повсеместная тенденция делать вещи меньше, то есть миниатюризация. Характерные размеры элементов широкого спектра технологий, как электронных, так и механических, сокращаются, и также с удвоенной экспоненциальной скоростью. В настоящее время уменьшение линейных размеров по каждому измерению происходит с коэффициентом примерно 5,6 за каждое десятилетие.

Вернёмся к экспоненциальному росту вычислений

Если мы рассматриваем экспоненциальный рост вычислений в правильной перспективе, в качестве одного из примеров широкой распространённости экспоненциального роста, основанного на информационных технологиях, что и является одним из множества примеров Закона ускоряющейся отдачи, то мы можем с уверенностью предсказать его продолжение.

В сопроводительной врезке, я даю упрощённую математическую модель Закона ускоряющейся отдачи, поскольку она имеет отношение к (двойному) экспоненциальному росту вычислительной мощности. Из формул, приведённых ниже, следует приведённый выше график непрерывного роста скорости вычислений. Этот график соответствует имеющимся данным для двадцатого века, проходит через все пять смен парадигм, и даёт прогноз на век двадцать первый. Обратите внимание, что скорость роста увеличивается медленно, но всё-таки в геометрической прогрессии.

Закон ускоряющейся отдачи применительно к росту вычислений

Ниже приводится краткий обзор Закона ускоряющейся отдачи на примере двойного экспоненциального роста скорости вычислений. Эта модель рассматривает влияние растущей мощности технологии в качестве стимула для развития своего собственного следующего поколения. Например, с более мощными компьютерами, и связанными с ними технологиями, мы получаем инструменты и знания, чтобы разработать ещё более мощные компьютеры, и сделать это ещё быстрее.

Обратите внимание, что данные за 2000 год и последующие периоды, представляют вычисления в нейронных сетях, поскольку ожидается, что именно этот вид расчётов, в конечном счёте, будет доминировать, особенно при эмуляции функций мозга человека. Этот тип расчётов является менее затратным, чем обычные (например, для Pentium III / IV) расчёты, с коэффициентом по меньшей мере 100 (особенно, в случае их реализации с использованием цифро-аналоговой электроники, которая будет хорошо соответствовать цифро-аналоговым электрохимическим процессам мозга). Коэффициент 100 соответствует примерно шести годам сегодня, и менее чем шести годам далее в двадцать первом веке.

Моя оценка производительности мозга составляет 100 миллиардов нейронов умножить на, в среднем, 1000 соединений на нейрон (вычисления происходят, в основном, в соединениях), и умножить на 200 операций в секунду. Конечно, эти оценки консервативно высоки, можно найти и более высокие и более низкие оценки. Тем не менее, даже гораздо более (или менее) высокие по порядку величины оценки, смещают прогноз всего на относительно небольшое число лет.

Некоторые из наиболее значимых дат этого анализа:

- Мы достигаем способностей одного человеческого мозга (2×1016 CPS (вычислений в секунду)) за $1000 около 2023 года.

- Мы достигаем способностей одного человеческого мозга (2×1016 CPS) за один цент около 2037 года.

- Мы достигаем способностей всей человеческой расы (2×1026 CPS) за $1000 около 2049 года.

- Мы достигаем способностей всей человеческой расы (2×1026 CPS) за один цент около 2059 года.

Модель имеет следующие переменные:

- V: Скорость (т.е. производительность) вычислений (измеряется в вычислениях в секунду отнесённых к их стоимости)

- W: Мировые знания применительно к проектированию и созданию вычислительных устройств

- t: Время

В модели предполагается, что:

Другими словами, мощность компьютеров является линейной функцией от знания о том, как их создавать. На самом деле, это консервативное предположение. Обычно, инновации улучшают V (производительность компьютера) в разы, а не на фиксированную величину. Независимые инновации умножают эффект друг друга. Например, новая технология полупроводников, такая, как CMOS, более эффективная методика разводки интегральных схем, и улучшение архитектуры процессора, такое, как конвейерная обработка, независимо и кратно увеличивают V.

Другими словами, W (знание) является кумулятивным, и мгновенное приращение знаний пропорционально V.

Это даёт нам:

Упрощая константы получаем:

Таким образом, это формула для "ускоряющегося" (то есть, растущего в геометрической прогрессии), результата, фактически "обычный закон Мура".

Как я уже упоминал выше, данные показывают экспоненциальный рост скорости экспоненциального роста. (Мы удваивали вычислительные мощности каждые три года в начале двадцатого века, каждые два года в середине века, и почти каждый год в течение 1990-х гг.)

Давайте рассмотрим другое экспоненциальное явление, которым является рост вычислительных ресурсов. Мало того, что каждое из вычислительных устройств (одинаковой стоимости) становится всё более мощным, как функция от W, но и их количество, используемое для вычислений, также растёт экспоненциально.

Таким образом, мы имеем:

- N: Расходы на вычисления

(как и раньше)

(расходы на вычисления растут со своей собственной экспоненциальной скоростью)

Как и прежде, мировые знания накапливаются, и мгновенное приращение пропорционально количеству вычислений, которые равны ресурсам, используемым для вычислений (N) умноженным на мощность каждого устройства (при его постоянной стоимости).

Это даёт нам:

Упрощая константы, получаем:

Это двойная экспоненциальная кривая, в ней скорость экспоненциального роста растёт со своей экспоненциальной скоростью.

Теперь давайте рассмотрим реальные данные. Возьмём параметры реальных вычислительных устройств и компьютеров в двадцатом веке:

- CPS / \$1K: вычислений в секунду за $1000

Данные по вычислительным устройствам двадцатого века соответствуют:

Мы можем определить темпы роста в течение определённого периода времени:

- Скорость роста =

- Человеческий мозг = 100 млрд (1011) нейронов × 1000 (103) соединений на нейрон × 200 (2×102) вычислений в секунду на одно соединение = 2×1016 вычислений в секунду

- Человеческая раса = 10 млрд (1010) человек = 2×1026 вычислений в секунду

Эти формулы и дают приведённые выше графики.

Уже сейчас ожидается, что суперкомпьютер от IBM "Blue Gene", создание которого планируется завершить к 2005 году, будет, по прогнозам, способен выполнять 1 миллион миллиардов операций в секунду (т.е. один миллиард мегафлопсов или один петафлопс). Это уже одна двадцатая производительности человеческого мозга, которую я консервативно оцениваю в 20 миллионов миллиардов операций в секунду (100 миллиардов нейронов на 1000 соединений в нейроне на 200 вычислений в секунду на одно соединение). В соответствии с моими предыдущими прогнозами, суперкомпьютеры достигнут мощности одного человеческого мозга к 2010 году, а персональные компьютеры сделают это примерно к 2020 году. К 2030 году потребуется уже небольшое поселение (около тысячи человек), чтобы соответствовать вычислительной мощности, доступной за \$1000. К 2050 году, за \$1000 можно будет получить вычислительные мощности, эквивалентные разуму всех людей на Земле. Конечно, это включает в себя только те мозги, которые всё ещё используют нейроны на основе углерода. Хотя человеческие нейроны, по сути, дивные творения, нам не стоит (да мы и не будем) их просто копировать при разработке новых компьютерных систем. Наши электронные схемы уже в десятки миллионов раз быстрее, чем электрохимические процессы нейрона. Большая часть сложности человеческого нейрона используется для поддержания его функций жизнеобеспечения, а не на возможности по обработке информации. В конечном счёте, мы должны перенести наши психические процессы на более подходящую вычислительную основу. Тогда нашим умам не нужно будет оставаться настолько маленькими, будучи ограниченным, как они ограничены сегодня, всего лишь ста триллионами нейронных связей, каждая из которых работает с медлительностью в 200 цифро-аналоговых вычислений в секунду.

Программное обеспечение интеллекта

До сих пор я говорил об аппаратном обеспечении вычислительной техники. Программное обеспечение ещё более показательно. Одним из основных допущений, лежащих в основе предсказания Сингулярности, является способность небиологических сред воспроизводить богатство, тонкость и глубину человеческого мышления. Достижение вычислительной мощности одного человеческого мозга, или даже поселения или нации, не будет автоматически давать уровень возможностей человека. Под человеческим уровнем я понимаю все разнообразные и изощрённые пути проявления человеческого интеллекта, в том числе музыкальные и художественные способности, творчество, способность физически перемещаться в пространстве, понимание, и адекватную реакцию на эмоции. Соответствующая мощность аппаратных средств является необходимым, но не достаточным условием. Организация и содержимое этих ресурсов - программное обеспечение интеллекта, также имеет решающее значение.

Прежде чем рассматривать этот вопрос, важно отметить, что, как только компьютер достигнет человеческого уровня интеллекта, он обязательно его перешагнёт. Ключевым преимуществом небиологического интеллекта является то, что машины могут легко делиться своими знаниями. Если я учу французский, или читаю Войну и мир, я не могу легко загрузить то, что узнал сам, вам. Вы должны получить эти знания тем же кропотливым путём, как это сделал я. Мои знания, встроенные в огромную структуру концентраций нейромедиаторов и нейронных связей, не могут быть быстро извлечены или переданы. Но мы не упустим возможности создания быстрых каналов передачи данных в наших небиологических эквивалентах кластеров человеческих нейронов. Когда один компьютер обучается навыку или приходит к пониманию чего-либо, он может немедленно разделить эту мудрость с миллиардами других машин.

В качестве современного примера - мы потратили годы обучения одного исследовательского компьютера на распознавание слитной человеческой речи. Мы пропустили через него тысячи часов записанной речи, исправляли его ошибки, и терпеливо улучшали его показатели. Наконец, он стал весьма искусными в распознавании (я продиктовал ему большую часть своей, недавно вышедшей, книги). Теперь, если вы хотите, чтобы ваш собственный персональный компьютер распознавал речь, его не нужно пропускать через тот же процесс заново; вы можете просто загрузить полностью подготовленные шаблоны за считанные секунды. В конечном итоге, миллиарды небиологических сущностей могут быть главным хранилищем всех знаний, приобретённых людьми и машинами.

Кроме того, компьютеры потенциально в миллионы раз быстрее, чем нейронные цепи человека. Компьютер также может точно запомнить миллиарды или даже триллионы фактов, в то время как мы с трудом запоминаем несколько телефонных номеров. Сочетание в машине интеллекта человеческого уровня со свойственным компьютерам превосходством в скорости, точности и совместном использовании знаний будет грандиозным.

Существует целый ряд убедительных сценариев достижения более высоких уровней интеллекта в наших компьютерах, в конечном итоге, приближающихся к уровню человека, и превосходящих его. Мы сможем развивать и обучать систему, комбинируя нейронные сети с массовым параллелизмом с другими парадигмами для того, чтобы понимать язык и строить модели знаний, в том числе уметь извлекать эти знания из письменных документов. В отличие от многих современных компьютерных "нейронных сетей", которые используют математически упрощённые модели человеческих нейронов, некоторые современные нейронные сети уже используют высоко детализированные модели человеческих нейронов, включающие точные функции нелинейной аналоговой активации и другие подобные детали. Хотя способность современных компьютеров к извлечению знаний и обучению на документах на естественных языках ограничена, их возможности в этой области быстро улучшаются. Компьютеры смогут самостоятельно читать, понимая и моделируя то, что они прочли, во втором десятилетии двадцать первого века. Затем мы сможем дать нашим компьютерам прочитать всю существующую в мире литературу - книги, журналы, научные издания, и другие материалы. В конце концов, машины будут собирать знания самостоятельно, роясь в Интернете, или даже в физическом мире, извлекая информацию из всего спектра средств массовой информации и информационных услуг, и обмениваясь знаниями друг с другом (что машины смогут делать гораздо легче, чем их создатели - люди).

Продолжение следует...