ИИ Microsoft научился разделять голос и эмоции

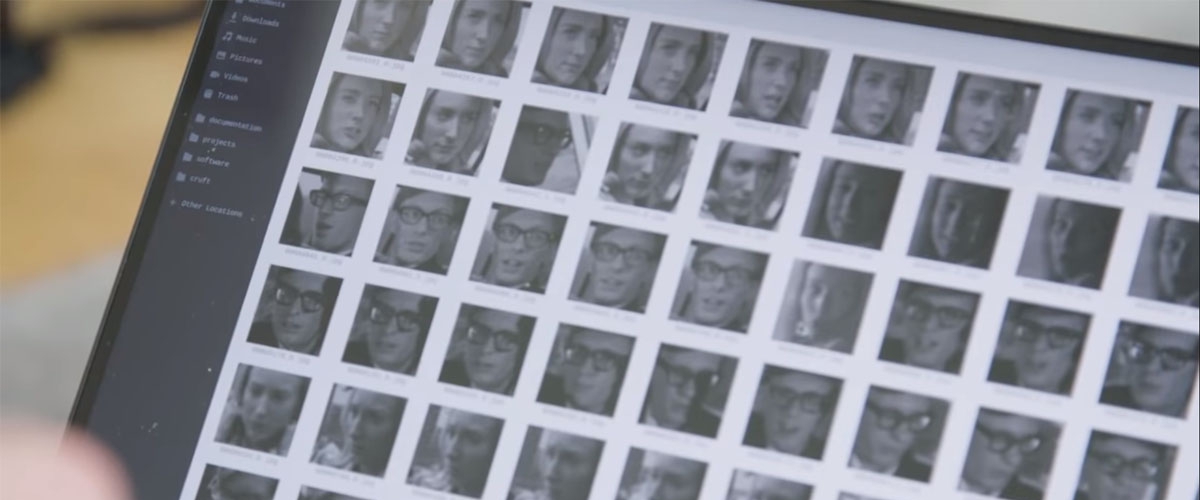

При наличии достаточно количества данных движения лицевых мышц любого человека легко синхронизировать с аудиозаписью любой речи. Команда Microsoft Research представила метод, существенно повышающий правдоподобие анимации «говорящих голов».

Обычно технологии создания анимированных изображений «говорящих голов» требуют чистой и относительно четкой записи речи, причем говорящий должен произносить текст нейтральным тоном. Метод, предложенный разработчиками из Microsoft Research, способен разделить аудиоклипы на фонетическую информацию и фоновые шумы. После этого для обучения и синхронизации можно использовать менее качественные и эмоционально насыщенные образцы, рассказывает VentureBeat.

«Как известно, речь богата на вариации. Разные люди произносят одно и то же слово в разном контексте с разной длительностью, амплитудой, тональностью и так далее. Вдобавок к лингвистической (фонетической) информации речь несет массу сведений об эмоциональном состоянии говорящего, его личности (поле, возрасте, национальности) и индивидуальных чертах, - говорится в статье. - Насколько мы знаем, наш метод - первый, который который улучшает качество звуковых образцов, предназначенных для обучения».

В основе подхода лежит вариационный автокодировщик (VAE), который анализирует образцы звука. Входящие аудиозаписи кодировщик раскладывает на различные представления, которые отвечают за содержание, эмоции и другие отличительные факторы. Затем их отправляют в генератор видео вместе с изображениями лица, которое должно произносить этот текст.

Авторы статьи протестировали свою модель на зашумленных и эмоциональных звуковых образцах, подтвердив ее превосходство над новейшими аналогами.

По словам разработчиков, в плане производительности им удалось по всем параметрам добиться уровня, сопоставимого с другими методами, которые обрабатывают только чистый, незашумленный звук. Более того, новый подход работает с равной производительностью вдоль всего эмоционального спектра, и совместим со всеми современными подходами генерации «говорящих голов».